Nos équipes, attentives à toute heure du jour et de la nuit, ont constaté ce week-end une désindexation aussi soudaine qu’inexplicable de nombreuses URL. Que s’est-il passé ? A-t-on une explication ? Et surtout, peut-on y remédier ? Digimood vous dit tout sur le bug Google de ce début du mois d’avril.

Bug Google : que s’est-il passé ce week-end ?

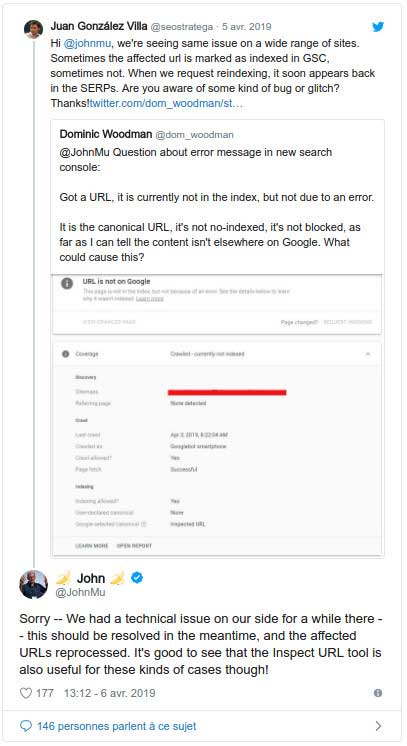

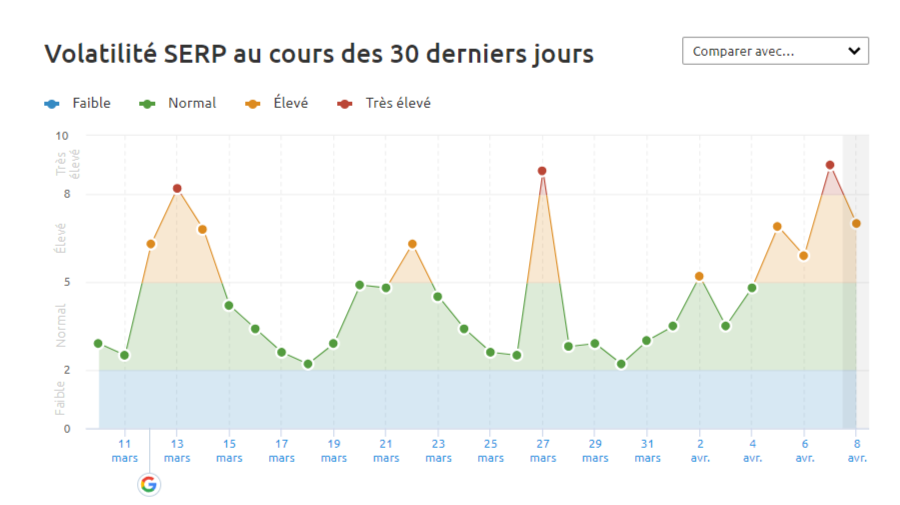

Les référenceurs ne dorment jamais et demeurent attentifs aux évolutions de leurs positions, étant alertés en temps réel par leurs applications préférées des éventuelles évolutions des positions de leurs sites. Dès le 5 avril, certains professionnels ont alerté la communauté sur la disparition de certaines pages de l’index Google. Elles ne ressortaient plus du tout dans les pages de résultats et leurs versions en cache avaient aussi disparu. Le nombre de pages concernées ne laissait aucun doute sur le caractère massif, et dans une certaine mesure inédit, de la situation. La communauté était en émoi et en quête de réponses. Beaucoup ont crié au bug et Google n’a pas tardé à réagir en la personne de John Mueller qui a confirmé l’existence d’un problème le 6 avril  Le phénomène a été particulièrement marqué ce week-end, comme en témoignent les applications qui analysent en temps réel la volatilité de la SERP de Google dont le SEMrush Sensor.

Le phénomène a été particulièrement marqué ce week-end, comme en témoignent les applications qui analysent en temps réel la volatilité de la SERP de Google dont le SEMrush Sensor.

SEMrush Sensor

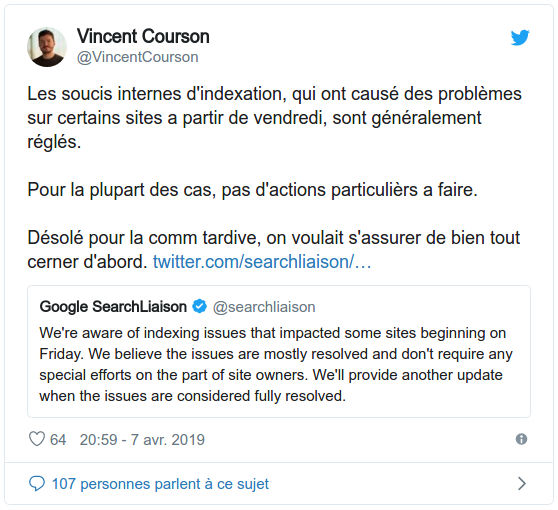

Cette désindexation massive n’est pas anodine, et certains sites ont vu leur trafic SEO chuter. Mais la situation semble avoir été corrigée depuis par Google.  Mais des problèmes subsistent encore malgré les annonces officielles. Et une URL peut être visible dans l’un des data centers de Google sans forcément ressortir sur les autres.

Mais des problèmes subsistent encore malgré les annonces officielles. Et une URL peut être visible dans l’un des data centers de Google sans forcément ressortir sur les autres.

Comment avons-nous réagi pour nos clients ?

L’existence d’un bug sous-entend logiquement sa correction… Mais sous quel délai ? Chaque visite perdue représente un manque à gagner pour nos clients. Il s’agit donc de réagir rapidement et efficacité, avec calme et sans fébrilité. Puisqu’une page est désindexée, le premier réflexe consiste à l’indexer à nouveau via Search Console. La fonctionnalité “Inspection de l’URL” permet de soumettre manuellement une page à l’indexation. Cette action manuelle peut fonctionner si quelques URL seulement sont concernées. Mais elle montre ses limites en cas de désindexation massive.

- Nous avons commencé par identifier les URL concernées par ce bug, site par site. Une perte des positions sur nos outils de monitoring nous a permis de connaître avec certitude toutes les pages stratégiques concernées.

- Nous nous sommes focalisés sur les URL désindexées les plus génératrices de visites SEO. Adopter cette démarche rationnelle a permis de limiter l’impact du bug sur le trafic SEO de nos clients.

- Nous créons aussi, selon les sites, un fichier sitemap.xml recensant les URL désindexées que nous communiquons à Google via Search Console. Cela permet d’accélérer la réindexation des pages concernées.

Des outils permettent aussi de réindexer massivement des URL sur Google. Nous ne les utilisons pas pour éviter d’envoyer tout signal négatif à Google, préférant passer plus de temps sur chaque dossier afin d’associer réactivité et qualité sur le long terme.

Comment de tels bugs sont possibles ?

L’algorithme de Google est une énorme machine composée de millions et de millions de lignes de codes, avec plusieurs mises à jour quotidiennes. Nous pouvons comparer l’algorithme à une ville tentaculaire, qui ne cesse de croître et de grandir dans toutes les directions. Parfois, la mise à jour consiste simplement à ajouter un feu rouge ici, à en supprimer un là-bas. Mais quelquefois, des quartiers entiers sont rasés et remplacés par de nouvelles constructions : de tels travaux ne sont pas anodins et peuvent avoir de sérieuses répercussions. Essayez d’imaginer la complexité effarante d’un tel algorithme, qui évolue sans cesse sous les effets conjugués de centaines d’ingénieurs et par lui-même grâce à une dose d’intelligence artificielle. Nous ne sommes pas loin, parfois, de la théorie du chaos de Ian Malcom, le mathématicien de Jurassic Park (référence un peu vintage, nous vous l’accordons) : la goutte peut, à cause des imperfections minimes de la peau glisser dans une direction ou dans l’autre.

Faut-il redouter la multiplication de ces situations ?

La complexification de l’algorithme et la dose de plus en plus massive de machine learning ne peuvent que mener à la multiplication de ce type d’événement dans les années à venir. Nous ne pouvons que recommander aux éditeurs de sites de se faire accompagner par une agence SEO : des professionnels compétents et vigilants vous apporteront les réponses adaptées en un temps record, et limiterons au maximum l’impact de tels bugs.