En route pour Paris, direction L’Usine – la Fabrique à deux pas du Stade de France ! Une partie de l’équipe Digimood était présente les 23 et 24 septembre derniers pour la reprise des événements SEO.

Cette année, Julien Ringard, Directeur SEO était accompagné d’une équipe SEO 100% féminine avec Léa Picosson, Noémie Roula et Fiona Debouvere, sans oublier Claire Aillaud pour représenter le pôle Netlinking !

Animées par des experts des leviers du SEO, les conférences se sont enchaînées tant pour reprendre les bases du référencement naturel que pour présenter les dernières mises à jour de l’algorithme.

1ère journée du SEOCamp

Nous commençons notre journée avec Morgane Surlenet avec « Que veut vraiment dire contenu pertinent en 2021 ». Intention de recherche, utilisateur, trafic et robots de Google étaient au programme. Après ce point contenu SEO & Marketing enrichissant, Kevin Richard (SEObserver) nous propose d’aller « Au-delà des graphiques Bullshit ouvrez le capot des outils SEO ». Confrontés à une grande quantité de données à traiter, nous gagnons du temps grâce aux outils SEO pour se concentrer sur des tâches plus chronophages. Toutefois, nous pouvons passer à côté de choses importantes en faisant une confiance aveugle à ces outils. Certains cas vous feront sans doute écho comme :

- La position moyenne (GSC) : dont la baisse de position traduit en réalité une dilution liée à l’acquisition de positions sur un nouveau panel de mots-clés.

- L’ajout massif de mot-clé positionné (SEMRush) ne signifie pas forcément que vous n’étiez pas positionné avant, cela peut simplement être lié à l’ajout de nouveaux mots-clés dans la base de données : un échantillonnage plus large ne signifie pas que vous n’étiez pas positionné avant.

- Et tout bêtement, la mauvaise échelle sur un graphique

- … Découvrez toutes les autres erreurs à ne pas commettre sur les slides de Kevin !

#IA & SEO

Nous avons ensuite retrouvé Nicolas Nguyen, pour aborder l’IA et GPT-3, l’un des sujets tendance dans le monde du SEO. Après des exemples concrets d’intelligence artificielle Nicolas met en parallèle le content marketing avec GPT3, un générateur de contenus par l’IA.

Depuis peu, la technologie NLP (“Natural Language Processing” ou “Traitement Automatique des Langues”), s’accélère, créant un intérêt pour plusieurs enjeux de budget marketing. Le modèle de langage créé par Open Ai intégre de multiples fonctionnalités :

- GPT 3 propose des résultats connectés en termes de typologie de contenus

- GPT 3 résume et simplifie les contenus au niveau scolaire souhaité

- GPT 3 génère des descriptions de produit

- GPT 3 génère des idées de contenus pour se distinguer sur le web

- GPT 3 créé des images à partir d’un texte

Bien évidemment, certaines limites sont déjà mises en évidence à commencer par la délivrance de données obsolètes selon les thématiques, des résultats incohérents en lien avec le fait que certains mots-clés d’actualité ne sont pas encore inclus dans la BDD et enfin des aberrations de propos en termes de thématiques sur le genre, la religion et la culture.

Pour conclure, les données GPT 3 sont à utiliser, mais uniquement sous couvert d’une relecture par l’humain et à associer à une stratégie SEO pour améliorer jusqu’à 8 fois ses chances de positionnement.

#STRATÉGIE NETLINKING

Côté netlinking, nous retrouvons de François Tréca sur « Comment gagner de l’argent avec les NDD grâce à l’industrialisation des PBN. »

Ce dernier nous a ainsi expliqué les différentes possibilités pour monétiser un PBN avec la vente d’articles sponsorisés, via des pages déjà existantes ou encore grâce à la location de liens sur la page d’accueil.

Il a mis l’accent sur certaines techniques à privilégier pour maximiser la vente de liens sur des PBN comme le choix d’une thématique porteuse, un équilibre entre site spécialisé ou généraliste ou encore le choix du NDD, qu’il soit expiré ou neuf.

Des outils comme Domstocks, ExpiredDomains ou encore PBNPremium nous permettent d’ailleurs de construire un PBN selon nos besoins ou celui du client.

« Quel potentiel et canaux pour la vente d’actifs immatériels : NFT, sites web et NDD » tel était l’intitulé de la conférence, donnée par Kevin Jourdan et Marc-Olivier Bernard à laquelle nous avons pu assister. Une présentation très intéressante qui nous en dit plus sur le process d’encadrements des achats et ventes d’actifs immatériels comme les sites web, saas, NDD ou encore les NFT (Non Fugible Token : objet numérique pour lequel on donne un code et qui est non reproductible).

Pour réaliser cette vente/achat d’un actif immatériel, il est possible de passer via le système des enchères (selon le nombre d’acquéreurs intéressés) ou en gré à gré via des outils spécialisés dans la vente d’actifs immatériels comme Dotmarket.eu, vente2site, microaquire, Sedo, Domainium, webfrance/flippa. Dans certains cas, il est possible que cette vente s’effectue en direct. Toutefois, ces actifs doivent faire l’objet d’une attention particulière pour éviter les arnaques et les mauvaises surprises.

Cette première journée à L’Usine se poursuit avec la conférence de Jacky Giang sur un « cas concret et retour d’expérience sur la stratégie de liens ». Les backlinks de qualité, tout comme les ancres exactes, l’intention de la requête mais aussi les EMD (Exact Match Domain) sont nécessaires et doivent être pris en compte selon les requêtes visées.

Après une première analyse de la SERP, la stratégie de liens commence en se concentrant sur les points clés suivants :

- La position actuelle du mot-clé

- Le nombre et la qualité de liens chez les concurrents

- Le nombre de liens que nous recevons déjà

- Le budget nécessaire à cette campagne

- La possibilité et la pertinence de s’inscrire sur la SERP (avons-nous une chance de nous positionner ?)

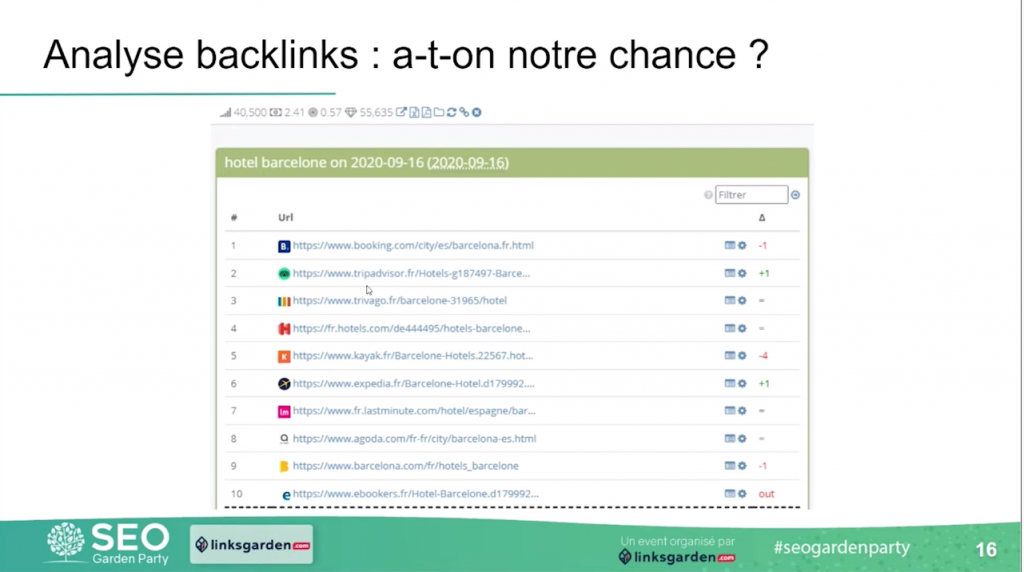

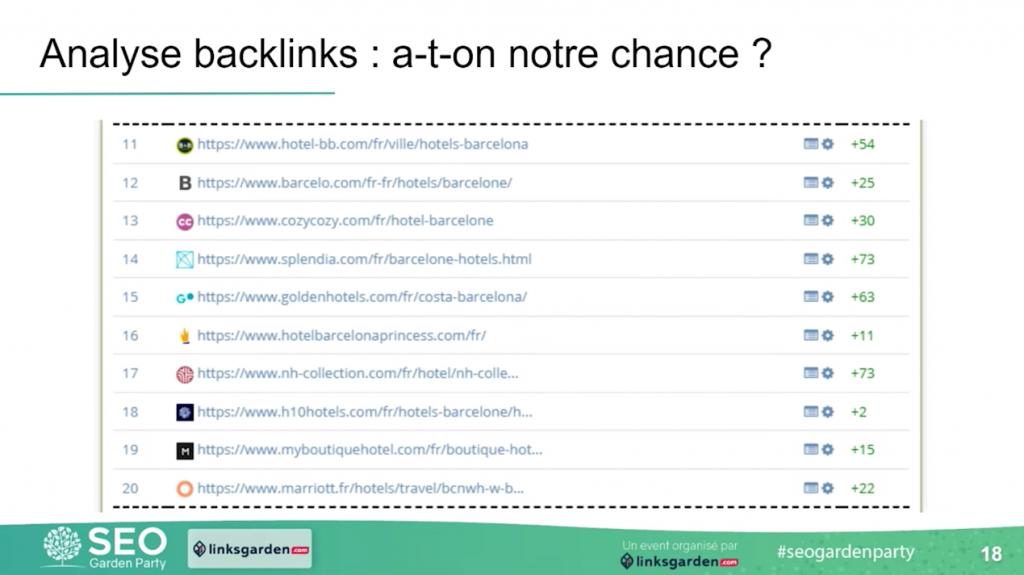

Pour illustrer ce dernier point, Jacky Giang nous présente les variations de positions de la requête “hôtel barcelone” via l’outil de Kevin Richard, SEObserver. Nous constatons que la première page sur la SERP de Google reste difficile d’accès avec des acteurs qui ont su asseoir, au fil du temps, leur légitimité. Cependant, à la seconde page sur la SERP de Google, nous remarquons que certains sites arrivent à se hisser en seconde page avec des prises de positions importantes (jusqu’à +73). On peut donc espérer s’inscrire en seconde page, mais cela reste-t-il pertinent pour le client ?

À noter : Au-delà de cette analyse, nous devons également prendre en compte les éléments d’optimisation On-site.

#CLINIQUE SEO

Pendant la pause déjeuner du Jeudi et celle du Vendredi après-midi, le SEOCamp proposait aux participants de faire auditer un site lors de la clinique SEO. Une fois n’est pas coutume, Digimood avait déjà participé à la clinique SEO les années précédentes avec Guillaume Robbe et cette année, c’est Léa Picosson, consultante SEO qui s’est prêtée au jeu ! Elle a pu analyser et donner des pistes d’améliorations sur des sprints de 30 minutes afin de délivrer des préconisations Quick-wins aux personnes en recherche de conseils SEO pour leurs sites.

À la suite d’un déjeuner sous le soleil Parisien, Julien Jimenez et Jeremie Crocq ont présenté un cas client : “Comment ranker en 3 mois sur la requête ultra concurrentielle : le CBD”.

La clé de cette réussite réside dans des optimisations Onsite et Onpage (quick-wins, maillage interne, sitemap scindé et optimisation sémantique), dans la prise en compte des intentions de recherche (transactionnelles), une importante campagne de netlinking – avec la plateforme NextLevel – poussée par la présence de sites dans Google Actu et un nom de domaine bien choisi.

#MOBILE FRIENDLY

Pour conclure cette première journée, Aymeric Bouillat s’est intéressé au SEO des sites mobile-Friendly. Lorsque l’on parle de mobile, la géolocalisation entre en jeu. Google, grâce aux brevets et comportements utilisateurs, est en mesure de deviner si l’internaute fait une recherche localisée explicite ou implicite. De ce fait, pour savoir si l’on doit ouvrir à l’indexation des pages localisées de type « Pizzeria + lieu», il faut coupler volume de recherche et intention de recherche.

Mais l’aspect mobile prend aussi en compte les différents modes d’intégration dont :

- Le Responsive design : un même code et URL avec une adaptation d’affichage selon les dimensions de l’appareil utilisé. Des lenteurs sont constatées dû au fait d’un double téléchargement d’éléments (menu, images)

- Le Dynamic Serving : un code HTML différent entre mobile et Desktop qui peut causer des différences de positions entre desktop/mobile car le site ne comporte pas exactement les mêmes éléments

- Le site mobile dédié : un sous-domaine (m.monsite) que Google ne “comprend pas” et peut avoir tendance à indexer en double avec l’URL en version desktop et également sa version mobile.

Ainsi, nous retiendrons pour qu’un site mobile soit SEO friendly, sa structure doit être réfléchie en mobile first, intégré en Dynamic Serving, contenir un fil d’Ariane, sans publicité intrusive et contenir du texte user-friendly (sans surcharge).

2ème journée du SEOCamp

Après une soirée riche en échanges avec une tablée de près de 100 personnes derrière le stade :), nous avons enchaîné la 2ème journée avec – pour commencer – une conférence des frères Peyronnet sur la réalisation d’un audit algorithmique. Sylvain et Guillaume ont dévoilé un exemple de livrable proposé à leurs clients avec une analyse des 3 piliers du SEO plutôt poussée afin d’aboutir sur une stratégie très précise sur la sémantique des contenus, des correctifs techniques et des actions de netlinking.

#R&D SEO

Notre équipe s’est ensuite rendue à la conférence de Alexis Rylko, véritable expert R&D SEO. Ce dernier met en avant une méthodologie des plus pertinentes pour analyser et conduire ses recherches. Il illustre, au travers de cas concrets, comme le volume de redirection au sein d’un fichier .htaccess, l’importance de cerner l’investigation autour des critères stratégiques à savoir :

- La typologie de recherches SEO

- Les données à utiliser

- Le protocole de test

- Les test field et lab

- Les biais méthodologiques et cognitifs

Alexis nous alerte sur le fait de bien prendre connaissance des différents paramètres impactant avant de se lancer dans la récolte de données, sans quoi, on peut être amené à divulguer des informations erronées sur le web.

#DROPSHIPPING

En tant que spécialiste du Dropshipping, Abdelilah Halim a présenté les “fails” qu’il a pu constater sur le web en Dropshipping. Du mauvais ciblage des personas, en passant par le choix du CMS ou d’un lancement sur une niche déjà saturée, il a délivré de précieux conseils pour créer un projet de Dropshipping rentable et surtout viable dans le temps.

#JAVASCRIPT

Parlons technique et Javascript avec Alexandre Pinat pour conclure ce SEOcampus 2021. Initialement utilisé comme surcouche visuelle ou tracker, le JS est, depuis 2014, interprété par Google. Connu sous les noms de React, Angular, Vue, Ember, Next et Svelte, de nombreux acteurs du web les utilisent (Leboncoin, L’Équipe, Marmiton, Galeries Lafayette), des intitulés qui nous rappelle notre livre blanc dédié JS.

Google ne peut pas indexer ce qu’il ne voit pas (problème du Client Side Rendering) et c’est tout l’enjeu d’un déploiement de sites en JS. Le premier point à prendre en compte est la crawlabilité qui diffère selon la méthode de rendu mise en place :

- Server Side Rendering (SSR) : Création à la demande des pages html côté serveur pour les envoyer déjà prêtes au navigateur.

- Serveur Site Generation (SSG) : Construction en statique en amont de toutes les structures de pages HTML à partir de modèles.

- Incremental static régénération (ISR) : Hydride de SSR + SSG où le contenu statique des pages est mise à jour instantanément sans avoir besoin de reconstruire l’intégralité du site.

Le second enjeu est la performance, liée au temps de chargement, plus que d’actualité avec les Core Web Vitals. Il est donc possible de le réduire en épurant les ressources JS avec le Tree-shaking (supprimer les obsolètes, doublons) ou le code-splitting (scission de fichiers pour n’appeler que l’utile)

Plus simplement, un site JS performant en SEO doit avoir des pages générées en HTML pour GoogleBot et des performances optimisées lors de l’appel des ressources JS.

Retrouvez toutes les slides des conférenciers sur : https://www.slideshare.net/SEOCamp

Ce qu’il faut retenir du SEOCamp Paris 2021

- Les outils SEO peuvent être extrêmement utiles mais il faut souvent prendre du recul pour mener des analyses pertinentes (exemple de la position moyenne sur GSC)

- La génération de contenu avec les AI va prendre de l’ampleur rapidement, pour le moment cela nécessite toujours une intervention humaine pour citer les sources, et ajuster le contenu.

- Le dropshipping n’est pas si facile que ça ! De nombreuses erreurs peuvent mener votre projet à sa perte, d’où les conseils d’Abdel à ce sujet

- Avec les mises à jour constantes de l’algo Google, faire des tests et mener des études complètes peuvent nous permettre d’en tirer des conclusions très intéressantes et ainsi mieux comprendre le fonctionnement du moteur de recherche.

- Le netlinking est une pratique qui continue de fonctionner et qui séduit ; en témoignent les nombreux acteurs présents lors de ce SEOCamp’Us (Linksgarden, Develink, Nextlevel et Netlinking.fr). Suite à la mise à jour Penguin qui avait signé l’arrêt du netlinking il y a presque 10 ans, on assiste aujourd’hui à une véritable industrie du backlinks avec des stratégies de liens toujours plus spécifiques et adaptées aux besoins du client : PBN, liens de niveau 2, location de liens sur la Home…

- Nous avons également participé aux conférences sur le Black Hat SEO, ces pratiques s’appliquent peu aux clients d’une agence SEO comme Digimood, pour autant nous avons pu en retenir plus un état d’esprit que des techniques vraiment utilisables dans notre quotidien.

#REMERCIEMENTS

Des conférenciers aux sponsors, de nombreux acteurs du SEO étaient présents ! Nous remercions chacun d’entre eux sans oublier l’association qui a permis de renouveler cet événement des plus appréciés par la communauté SEO ! Mention spéciale à la licorne du SEOCamp O2Switch avec Kovann Ly, toujours là pour mettre de la bonne humeur !